论文《Deep Region amd Multi-label Learning for Facial Action Unit Detction》– CVPR.2016.369.

1. 摘要

-

Region learning(RL) 区域学习

- AU 在人脸部的稀疏区域活动,RL 旨在在这些特定区域学习以获得更好的效果。

-

Multi-label learning(ML) 多标签学习

- 强有力的 AU 相关性统计学证据证明,ML 是模拟 AU 检测的最自然(最接近人思维)的方法。

- 一些 AU 经常一同出现,例如 AU6 和 AU12 经常在微笑中共同出现,基于这些相关性,ML 尝试联合学习多个 AU 作为一个分类问题。

-

提出 Deep Region and Mutil-label Learning(DRML)

- 一个统一的深度网络同时解决以上两个问题。

- 与之前的分别解决 RL 和 ML 的研究不同,DRML 通过构造解决了这两个问题,允许两个看似无关的问题直接的进行交互。

- 完整的网络是端到端可训练的。

- 完整的网络是会自动的对区域内 有利于提升鲁棒性的变化 进行学习。

-

一个重要的方面:提出了一个新颖的区域层(Region-layer)

- 使用前馈网络,导出重要的(感兴趣的)面部区域,迫使学习权重捕捉到面部信息。

- 替代 局部连接的层(locally connected layers) 和 传统卷积层之间的 连接设计。

-

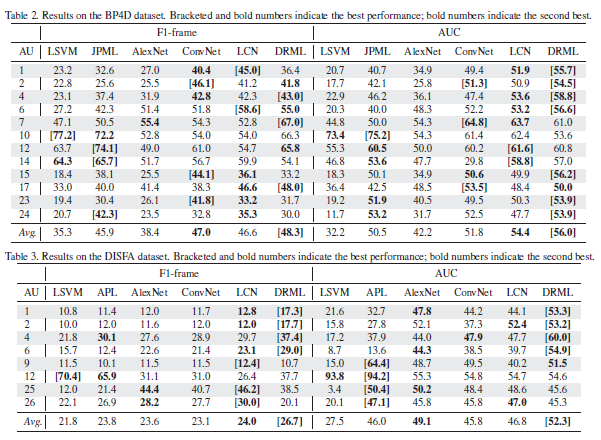

在 BP4D 和 DISFA 上的实验结果:

- 与其他方法相比,DRML 在数据集内和跨数据集的情况下具有最高的平均 F1 得分和 AUC。

2. 引言

-

介绍 RL 和 ML 的目的

-

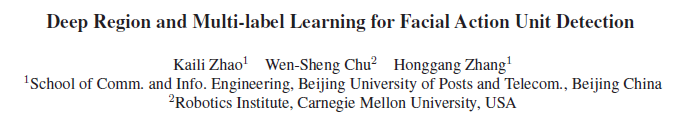

Patch learning

- 如图 1(a)所示,图片被分割成均匀的 patch,然后对每个 patch 对应相应的参数,更高的重要性意味着对特定 AU 此类 patch 具有更高的相关性。

- 由于所选的 patch 们的空间依赖性,他们比单个特征值更有效,并且对噪声有更强的鲁棒性。

- 但是 patch 是手动定义的,并且现有的大多数工作忽略了 AU 之间的关系。

- 如图 1(a)所示,图片被分割成均匀的 patch,然后对每个 patch 对应相应的参数,更高的重要性意味着对特定 AU 此类 patch 具有更高的相关性。

-

利用 AU 相关性的 ML

- 利用 FACS 启发式或 Ground truth labels 的统计数据得出 AU 的相关性,然后将 AU 相关性插入到学习中,鼓励(加强)具有高相关性的 AU 的发生概率。

- 但是,由于开发者的主观性,这些 AU 的相关性可能出现偏差,或在不同的数据集之间有不同。

-

作者提出的 DRML

- DRML 并没有像如图 1(a)那样,将面部均分为网格,而是将与某个 AU 相关的区域权重从高向低分布,如图 1(b)所示,产生类似与热力图的结果。

- 由于网络本身的多标签特性,RL 和 ML 可以在网络中自然地相互作用,而不是在后续解决或是交替解决。

- 引入新的 Region layer(区域层),作为局部连接层。(前边已经提过)

- 端到端可训练,与其他模型相比,学习 AU 相关性能更好的收敛。

3. 相关工作

-

Region Learning(RL)

-

Multi-label Learning(ML)

-

CNNs

4.DRML

普通的卷积层的常见前提是——整个图像共享卷积核,但是对于面部这种结构化的研究对象来讲,这将不能捕获局部的、微小的变化。为了弥补这个限制,并利用 AU 的相关性,我们构建了 DRML 网络。

-

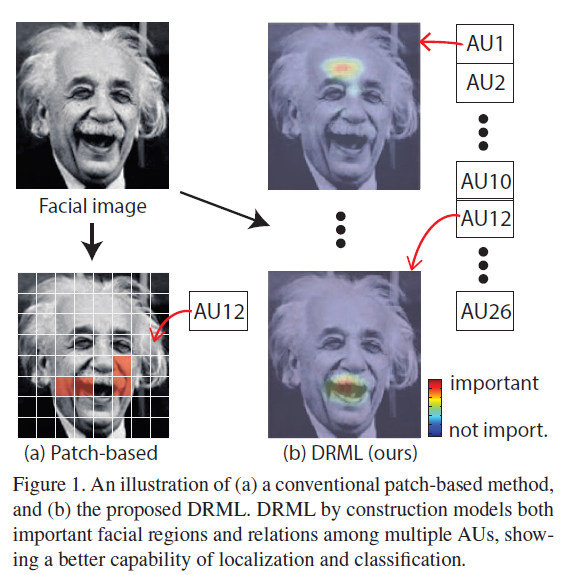

DRML 结构

- 网络结构比较直观。

- fc9:与 AlexNet 的 1000 中相比,AU 的种类很少,于是将 fc9 的输出由 4096 调整为 2048。

- 参数:共 56m 参数,少于 AlexNet 的 60m 和 DeepFace 的 120m。

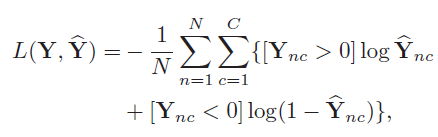

- Loss:本文使用 Sigmoid 交叉熵函数 (Sigmoid cross-entropy loss)。C 为 AU 的数量,N 为样例数。其中 [x] 为指标函数,当 x 为 True 是值为 1,其他情况下为 0。

-

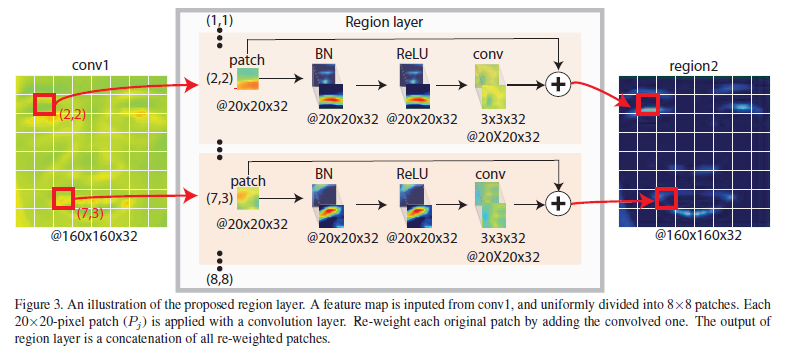

Region layer

- 区域层结构示意如图

- DeepFace 引入局部连接层用于人脸验证,达到了不错的性能,但参数过多,>120m。

- AU 数据集的数量不足够,例如 BP4D 数据集中只有 14w 帧,在 DeepFace 这样大的网络上很容易过拟合。

- 结构如图 3 所示:Patch –> 局部卷积 –> 叠加(跳层)。局部卷积独立更新某个部位的学习权重。跳层有助于避免梯度消失问题,简化学习。

-

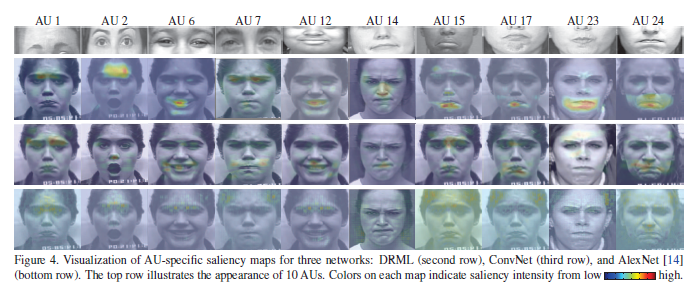

Region layer 能为 AU 检测捕捉到什么?

- 如图 4,第二行是 DRML 的结果。

-

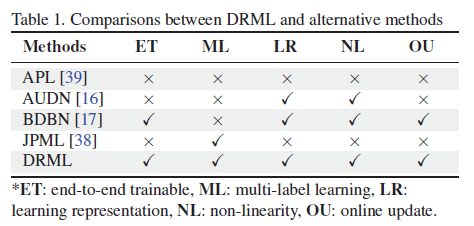

与相关工作的比较

5. 实验

-

数据集

- BP4D:12 个 AU,328 个视频,41 人 * 8 视频,14w 帧有效图片。每个视频每个 AU 提取 100 正样例,200 负样例。按照 FERA 2015 划分方法进行训练,便于与现有最佳情况对比。

- DISFA:8 个 AU,26 个人在观看视频时的表情情况的视频,13w 帧有效图片。每个视频 800 正样例,1600 负样例。

-

评价标准

- F1-score

- AUC

-

结论

正文完

请问下对于bp4d来说,样本数总共是328*300*12吗